Here is a blog post tailored for My Core Pick.

停止挖掘,开始提问:RAG 如何重塑非结构化企业数据

我希望你想象这样一个场景。那是周二下午 2:00。

你正在寻找一份三年前签署的供应商合同中的特定条款。

你知道它确实存在。你记得相关的邮件往来。你还记得你老板竖起大拇指表示同意的那条 Slack 消息。

但你就是找不到它。

你搜索“供应商合同”。没有什么有用的结果。你搜索供应商的名字。出现了 400 个结果。

你开始一个个打开 PDF 文件。你在归档的邮件中翻找。你浪费了四十五分钟,仅仅是为了找到你已经拥有的信息。

这就是“挖掘模式(Digging Paradigm)”。坦率地说,它正在扼杀企业的生产力。

我们被淹没在数据中,却极度渴望洞察力。

但就在此刻,一种转变正在发生。我们正从挖掘转向提问。

它被称为 RAG(检索增强生成,Retrieval-Augmented Generation),这是自搜索栏诞生以来企业数据管理领域最重要的一项进展。

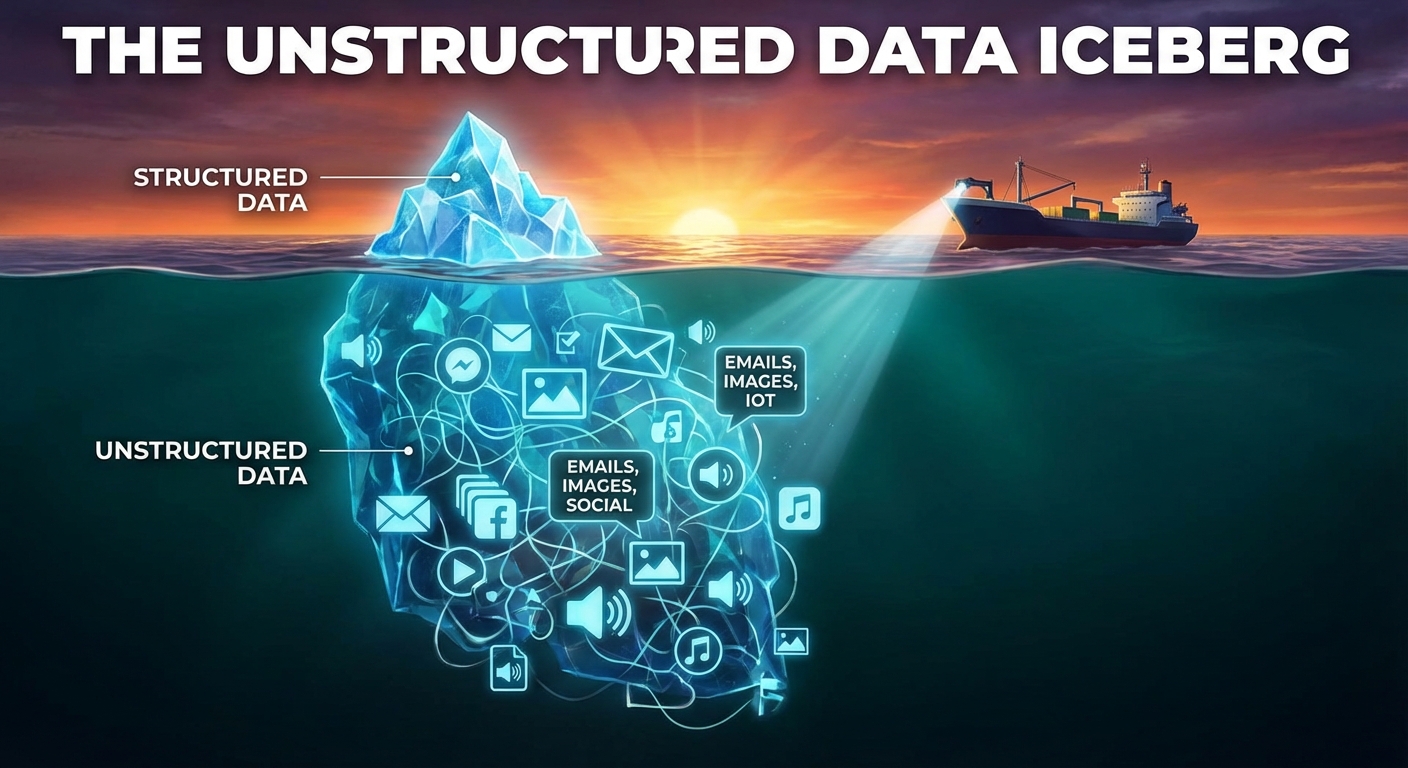

问题所在:非结构化数据冰山

有一个统计数据让我夜不能寐。

理想情况下,大约 80% 的企业数据是“非结构化”的。

结构化数据很简单。它存在于 Excel 表格、SQL 数据库和 CRM 字段中。它整齐地排列在行和列里。它很整洁。

非结构化数据则是一团乱麻。

冰山之下

非结构化数据包括 PDF、内部维基(Wiki)、冗长的邮件往来、Slack 对话、视频转录稿和演示文稿。

这是实际工作发生的地方。这是上下文存在的地方。

但是传统的搜索工具在读取这些内容方面表现糟糕。

标准的企业搜索依赖于关键字。如果你没有输入文档中出现的确切关键字,你就没戏了。

这就像试图在一个书皮都被撕掉的图书馆里找一本书。

通用 AI 的局限性

所以,你可能会想,“为什么不直接使用 ChatGPT?”

公共大语言模型(LLMs)令人难以置信,但对于商业用途,它们有两个致命的缺陷。

首先,它们不知道你的秘密。它们没有读过你的内部备忘录或你的专有代码。

其次,它们会产生幻觉。如果它们不知道答案,为了取悦你,它们可能会编造一个。

在商业环境中,幻觉不是一个小怪癖。它是一个隐患。

这正是 RAG 填补空白的地方。

RAG 登场:“开卷”考试

让我们暂时抛开专业术语。

要理解检索增强生成(RAG),回想一下你的学生时代。

使用标准的 LLM(如通用的 GPT-4)就像是凭记忆参加考试。

学生很聪明。他们读过很多书。但如果你问他们今天早上发生的具体事件,他们不会知道。他们的记忆冻结在过去的时间点。

给 AI 一张小抄

RAG 改变了考试规则。

RAG 允许学生参加“开卷”考试。

当你提出问题时,AI 不仅仅依赖于它的训练记忆。

相反,它会停下来。它跑到你公司的私人文件柜前。它拿出与你的问题确切相关的文档。

然后,它会立即阅读这些文档。

最后,它仅根据这些文档来构建答案。

结果

答案是准确的,因为它引用了你的数据。

它是最新的,因为它读取的是你五分钟前上传的内容。

关键是,它停止了挖掘。你不必去寻找文档。你只需要提出问题。

运作原理:幕后机制

我保证这里不会讲得太技术化。但了解其机制有助于你看到它的价值。

RAG 不是魔法。它是一个三步工作流。

1. 索引(向量数据库)

首先,我们获取所有那些混乱的非结构化数据——你的 PDF、HTML 文件和文本文档。

我们将它们切成小块。

然后,我们将这些块转化为“向量”。

向量只是一长串数字,代表文本的含义,而不仅仅是关键字。

例如,关键字搜索认为“Car(汽车)”和“Automobile(机动车)”是不同的。向量搜索则理解它们在语义上是相同的。

我们将这些向量存储在一个专门的数据库中。

2. 检索(搜寻)

现在,你输入一个查询:“我们要承包商远程工作的政策是什么?”

系统将你的问题转化为向量。

它在数据库中查找在数学上与你的问题相似的文本块。

它检索出你公司手册中最相关的 3 到 5 个段落。

3. 生成(合成)

这是最酷的部分。

系统向 LLM 发送一个提示,看起来像这样:

“用户问:远程工作政策是什么?以下是在数据库中找到的上下文:[插入检索到的段落]。请仅使用此上下文回答用户。”

LLM 充当总结者和合成者。

它给出一个通俗易懂的答案,通常还会附上指向源 PDF 的引文。

为什么这会改变一切

我相信这项技术从根本上改变了员工体验。

它让我们从“搜索者”转变为“知晓者”。

以下是我看到的这种技术在现实世界中发挥作用的三个具体方式。

1. 终结对“幻觉”的恐惧

企业采用 AI 的最大障碍之一是信任。

高管们害怕 AI 会编造财务数据。

有了 RAG,你可以强制 AI 展示它的工作依据。

如果系统在检索到的文档中找不到答案,它可以被编程为说“我不知道”,而不是编造内容。

这种基于事实的特性使得 AI 在商业使用中变得安全。

2. 即时入职培训

想象一下新员工入职的第一天。

通常,他们会花几周时间拍拍同事的肩膀问:“我该如何申请带薪休假(PTO)?”或者“我该如何配置 VPN?”

有了支持 RAG 的聊天机器人,他们只需询问系统。

系统会从 Confluence 页面、HR PDF 和 IT Slack 频道历史记录中提取信息。

新员工得到即时答案。高级工程师也不会被打扰。

3. 如虎添翼的客户支持

你的支持代理可能正被淹没在文档中。

当客户提出复杂的技术问题时,代理通常会让客户稍作等待,自己去翻阅手册。

有了 RAG,代理只需输入问题。系统会检索技术手册、发布说明和错误报告。

它会在几秒钟内生成建议的回复。

我们谈论的是将解决时间缩短 50% 或更多。

入门指南:不要贪多求全

如果你正在考虑实施这项技术,我有一些建议。

不要试图一次索引所有内容。

RAG 很强大,但它依赖于“垃圾进,垃圾出(Garbage In, Garbage Out)”。

从高价值数据开始

选择一个特定领域。HR 政策是一个很好的起点。或者是特定产品的技术文档。

清理这些数据。确保文档是最新的。

如果你给系统输入了 2019 年和 2024 年相互冲突的政策,AI 会感到困惑。

安全至上

这一点至关重要。

如果你索引了 CEO 的私人邮件和工资单电子表格,然后给实习生一个聊天界面,那你就麻烦了。

你的 RAG 系统必须遵守访问控制列表(ACL)。

检索步骤应该只提取特定用户有权查看的文档。

永远不要跳过这一步。

未来是对话式的

我们正走向一个软件界面仅仅是自然语言的世界。

我们将不再导航菜单。我们不再过滤列。我们不再使用高级搜索语法。

我们只会说话。

“给我看上周的销售趋势与 Q3 预测的对比。”

“总结这五份法律合同中概述的风险。”

“根据工程团队的更新起草一封解释延误的邮件。”

RAG 是使这一切成为可能的引擎。

它把你那些尘封的、非结构化的、被遗忘的数据变成一个活生生的、会呼吸的知识库。

所以,停止在文件夹中挖掘。停止为了找到一句话而阅读 50 页的 PDF。

开始提问。

你的数据已准备好回答。